- 与您的网络分享此项目:

- 下载

连续波亚太

NVMe for AI:一个强大的配对

NVMe存储能力提供带宽和低延迟,这是人工智能和机器学习应用程序访问和管理它们使用的大量数据所需要的。

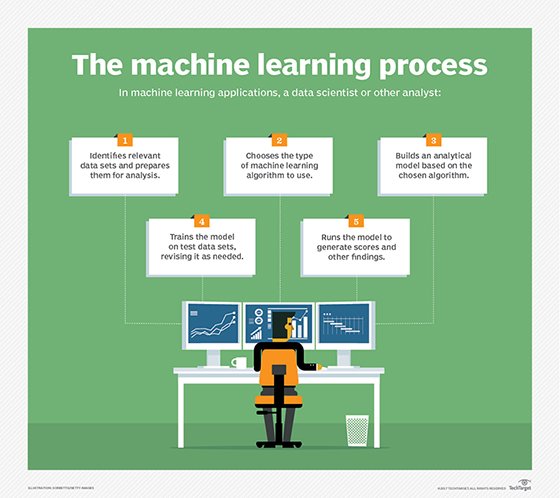

人工智能和机器学习系统长期以来一直依赖于传统的计算架构和存储技术来满足其性能需求。但这种情况不会持续太久。今天的人工智能和机器学习系统——使用gpu、现场可编程门阵列和特定应用集成电路——处理数据的速度比它们的前辈快得多。

与此同时,用于训练的数据集这些智能系统越来越大。为了满足这些日益增长的需求,采用者正在转向NVMe来实现人工智能功能。

NVMe提供比SAS和SATA更大的带宽和更低的延迟,使最大的性能要求的工作负载。例如,机器学习训练使用数以百万计的数据示例来训练算法,以便它们能够对新数据做出决策。

提供NVMe ssd的美光科技(Micron Technology)高级技术营销经理Jason Echols表示:“NVMe已经从本世纪初推出时的前沿发展到2019年的人工智能主流存储选项。”

Solarflare Communications董事兼技术传讯者Scott Schweitzer表示,传统旋转存储的访问时间比当前NVMe技术慢三个数量级。Solarflare Communications提供旨在加速云数据中心应用和电子交易平台的技术。

他说,传统的存储方式是用磁头读取旋转的磁碟,本质上是串行的。“控制器只提供少量的队列,这些队列通常映射回磁盘上的磁头数量,”他说。相比之下,NVMe设备具有64000年队列,使它们能够为多达64,000个并行的数据请求提供服务。

更快更好

NVMe已经从本世纪初推出时的前沿发展到2019年成为AI的主流存储选项。 杰森Echols美光科技高级技术营销经理

戴尔EMC的人工智能和分析产品营销经理马修•豪斯曼(Matthew Hausmann)表示,Flash已经是人工智能平台的关键组件,这些平台将高性能、可扩展存储与gpu加速计算结合起来,以消除I/O瓶颈,并推动大规模的人工智能洞察。“越快越好,因此NVMe是这些解决方案的自然发展,提高了额外的性能,使它们更接近实时。”

Schweitzer预计NVMe将在人工智能环境中取代传统存储。人工智能应用程序通常需要大量的数据集,随着应用程序变得更加面向性能,等待传统磁盘子系统很快就成为计算领域的长杆。

“直到几年前,网络才是最右边的性能曲线,这限制了整个系统的性能,”他观察到。“随着我们转向10gb以太网,然后是25gbe,很快是100gbe,后来是400gbe,网络正迅速接近本地内存访问速度。”

AI应用程序运行在基于gpu的系统分布式块存储供应商Excelero的首席架构师Kirill Shoikhet表示,可以使用NVMe存储来满足几乎任何规模的GPU场,其性能远远超过传统存储技术。他指出:“用于人工智能和(机器学习)应用的现代GPU对数据有惊人的胃口,每台GPU高达16gbps。”“用慢速存储或来回复制数据浪费时间,是在浪费你所购买的最昂贵的资源。”

NVMe用于AI用例

NVMe在特定的AI用例中工作得很好,例如训练机器学习模型还有检查点,在那里可以对正在进行的训练进行备份。机器学习包括两个阶段:基于从数据集学到的知识训练模型,然后实际运行模型。“培训模型是最需要资源的阶段,”Shoikhet解释说。“用于这一阶段的硬件——通常是高端gpu或专门的soc(芯片上的系统)——购买和运行都很昂贵,所以应该总是很忙。”

用于模型训练的现代数据集可能是巨大的。核磁共振扫描例如,如果将其用于机器学习,则可能需要数万甚至数十万张图像。

Shoikhet说:“即使训练本身从RAM中运行,记忆也应该从非易失性存储器中获取。”分页旧的训练数据并引入新数据应该尽可能快地完成,以保持gpu运行。这意味着延迟也应该很低,他说,对于这种类型的应用程序,NVMe是唯一既支持高带宽又支持低延迟的协议。

检查点设置也受益于NVMe技术。Shoikhet解释说:“如果训练过程很长,系统可以选择将内存的快照保存到非易失性存储中,以便在崩溃时从快照重新启动。”“NVMe存储也非常适合这种用途。”

潜在的缺陷

完全理解存储I/O配置文件是很重要的人工智能应用以便将正确的NVMe SSD匹配到特定的需求。Echols说:“一些人工智能环境,尤其是培训,是以阅读为中心的,这意味着你可以在不花大把银子的情况下实现成本和性能效益。”

对于所有涉及NVMe用于人工智能的用例,Hausmann建议避开专有的NVMe存储技术,转而寻找内置在旗舰企业产品中的NVMe。“你可能会在纸上损失几纳秒,但当你的系统继续运行,并在6个月后仍能得到支持时,你将领先数光年。”

相关资源

- 成熟的AI解决方案,易于部署,生产就绪和成本效益…datadirect网络