回答了5个NVMe-oF实现问题

想知道关于在fabric上实现NVMe的更多信息,它在哪里有用,应该考虑什么?找到这些问题和围绕这项技术的其他问题的答案。

NVMe over fabric正在进入企业,使各组织能够在其基础设施中扩展NVMe的高性能、低延迟优势。

一个NVMe-oF实现映射NVMe主机和共享内存之间的命令和响应,促进通信。它扩展了NVMe设备可访问的距离,并支持扩展到多个设备。

对于大多数组织来说,NVMe技术的第一步是使用传统网络连接到存储网络的NVMe全闪存阵列。超过60%的全闪存阵列会这样做使用NVMe存储介质根据G2M Research的预测,到2022年。之后,根据性能需求,可能会转到NVMe-oF。G2M还估计,超过30%的AFAs将使用NVMe-oF在未来三年内连接主机或扩展架。

然而,NVMe-oF并非没有复杂性和挑战。你必须收集大量信息并在采取行动之前回答一些问题。下面是在部署这个新的关键技术之前,需要回答的五个重要的NVMe-oF实现问题。

NVMe-oF实现选项有哪些?

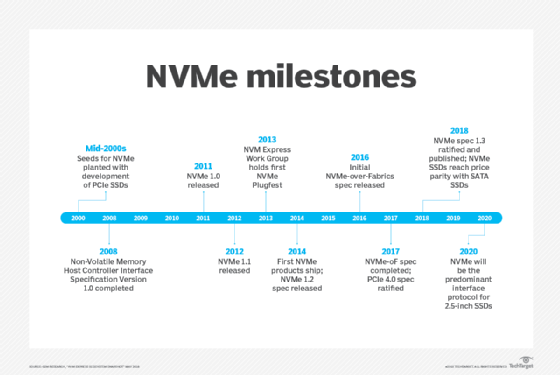

当2016年最初的NVMe-oF规范发布时,它提供了对光纤通道(FC)和远程直接内存访问(RDMA)结构的支持,包括InfiniBand、融合以太网上的RDMA和RDMA协议。2018年11月发布的NVMe-oF 1.1规范补充道TCP作为fabric选项.

使用FC和RDMA,数据可以从主机传输到阵列,然后再传输回来,而不需要复制到内存缓冲区和I/O卡,这是使用标准TCP/IP堆栈必须做到的。这种方式降低了CPU负载和数据传输延迟,提高了存储性能。然而,FC和RDMA比TCP更复杂,在实现NVMe-oF时可能需要特殊的设备和配置。

企业可以使用TCP NVMe-oF传输通过标准的以太网和internet进行绑定,使其更容易实现。它不需要任何重新配置更改或特殊设备,消除了在FC或RDMA上使用NVMe所涉及的许多复杂问题。

实施NVMe-oF时必须考虑哪些因素?

NVMe-oF的设计目的是使用组织的现有存储结构,但这假设现有存储基础结构与NVMe-oF兼容。一些供应商并不严格遵守NVMe-oF标准,而是使用一种可能导致兼容性问题的专有方法。

另一个需要考虑的领域NVMe-oF实现确保存储基础设施有足够的吞吐量。如果系统启动器和目标器之间的连接跟不上物理NVMe存储设备的速度,系统延迟可能会增加。检查存储系统软件是否更新也很重要。旧的设备驱动程序和操作系统内核会导致问题。

NVMe-oF在哪里离开机架级PCIe?

在NVMe-oF出现之前,数据中心似乎正朝着这个方向发展机架规模,交换PCIe fabric.EMC收购后解散的DSSD公司开发了一种技术,利用PCIe交换机在机架上的主机之间共享一块闪存。当时,DSSD的100微秒(µs)延迟优于全闪存阵列厂商的1毫秒延迟。

但随后NVMe-oF出现了,它与DSSD的100µ延迟相匹配,同时让客户使用他们现有的标准以太网和FC网络,这一发展暂时搁置了支架级PCIe。不过,考虑到Gen-Z财团的重点是开发机架规模的基础设施共享GPU和内存以及存储和I/O卡。

NVMe-oF如何帮助扩展存储?

扩展存储架构的工具使用额外的服务器或节点来提高其性能和容量。在过去,扩展工具的实现往往比较复杂。但NVMe-oF正在改变这一切通过绕开传统存储架构的局限性和复杂性。

NVMe-oF的优势在于在主机和存储介质之间创建了更直接的路径。因此,数据不能通过中央控制器传输。这种更直接的I/O路径减少了路径的长度,使单个主机能够与多个驱动器通信,反之亦然。这种方法降低了存储系统的延迟并提高了扩展能力。

NVMe和NVMe- of是否解决了所有存储性能问题?

NVMe技术极大地提高了服务器或存储控制器CPU与通过SAS和SATA ssd连接的flash ssd之间的性能。和NVMe-oF降低了延迟提高了共享存储的性能。然而,NVMe和NVMe- of还暴露了另一个性能挑战:CPU阻塞点在服务器或存储控制器中。

最新的处理器支持越来越多的ssd。随着越来越多的驱动器被使用,支持硬件也变得越来越复杂,需要IT处理和管理的cpu、驱动器、驱动器抽屉、交换机、适配器、收发器和电缆也越来越多。更多的硬件也会导致整体性能的边际回报递减。

这种NVMe-oF实现性能挑战的原因是存储软件不是为CPU效率而设计的。解决这个问题的一种方法是重写存储软件,使其更有效。一些供应商,如StorOne,采取这种方法。其他人正在尝试替代解决方案,比如添加更多的cpu,在NVMe ssd前放置动态RAM缓存,以及使用计算存储在NVMe驱动器上放置更多的处理器和RAM。